GLM-4.6: Model AI Baru dengan Coding & Reasoning Lebih Kuat

Dua hari lalu, dunia AI kedatangan “pemain baru” yang langsung ramai dibicarakan: GLM-4.6. Model terbaru dari seri General Language Model (GLM) ini disebut-sebut membawa peningkatan signifikan dibanding versi sebelumnya, GLM-4.5.

Bukan cuma sekadar update minor, GLM-4.6 hadir dengan kemampuan reasoning yang lebih kuat, jendela konteks lebih panjang, serta performa coding yang diklaim mampu menyaingi model-model besar lain di kelasnya.

Singkatnya, rilis ini jadi kabar penting bagi developer, peneliti, maupun siapa saja yang tertarik dengan perkembangan large language model.

Baca Juga: Decision Tree Classifier: Konsep, Cara Kerja & Contoh

Apa Itu GLM-4.6?

GLM-4.6 adalah model bahasa terbaru dari seri General Language Model (GLM) yang dikembangkan oleh Zhipu AI, salah satu pemain besar di ekosistem AI Tiongkok.

Model ini dirilis hanya dua hari lalu sebagai penerus GLM-4.5 pada tanggal 30 September 2025, dan langsung menarik perhatian karena positioning-nya yang berani menantang model global seperti Claude Sonnet maupun DeepSeek.

Berbeda dari rilis minor, GLM-4.6 memang dirancang sebagai lompatan besar.

Ia hadir untuk melayani kebutuhan nyata mulai dari reasoning, coding, searching, writing, hingga aplikasi berbasis agen (agentic applications).

Dengan rilis ini, Zhipu AI menegaskan ambisinya untuk menempatkan GLM sebagai salah satu LLM paling kompetitif di dunia.

Apa yang Baru di GLM-4.6?

Sebagai iterasi terbaru, GLM-4.6 membawa peningkatan besar di berbagai domain: mulai dari reasoning, coding, long-context processing, sampai integrasi dengan agen. Berikut beberapa hal yang jadi sorotan:

1. Longer context window

Kapasitas konteks diperluas dari 128K → 200K tokens. Ini memungkinkan GLM-4.6 membaca dokumen, kode, atau percakapan super panjang tanpa kehilangan konsistensi, sekaligus mendukung tugas agentic yang lebih kompleks.

2. Superior coding performance

Performa coding melonjak signifikan. Dalam benchmark seperti LiveCodeBench v6 dan 74 tes coding nyata (Claude Code, Cline, Roo Code, Kilo Code), GLM-4.6 konsisten unggul atas Claude Sonnet 4 maupun model domestik lain.

Bahkan, output front-end page yang dihasilkan lebih rapi dan “polished” secara visual.

3. Advanced reasoning

Model ini menunjukkan peningkatan jelas pada soal-soal logika dan matematika.

GLM-4.6 juga mendukung penggunaan tools saat inference, membuat reasoning lebih natural dan akurat.

4. More capable agents

Dari sisi agen, GLM-4.6 lebih luwes digunakan di search-based agents dan terintegrasi lebih efektif dengan framework agen yang kompleks.

Ini penting untuk aplikasi dunia nyata seperti RAG (retrieval-augmented generation) dan autonomous agents.

5. Refined writing

Untuk penulisan, GLM-4.6 lebih selaras dengan preferensi manusia. Gaya bahasa lebih halus, natural, dan performa di skenario role-playing terasa lebih hidup dibanding versi sebelumnya.

Bagaimana Performa GLM-4.6 di Benchmark?

Peningkatan GLM-4.6 bukan cuma klaim, tapi terbukti di berbagai evaluasi.

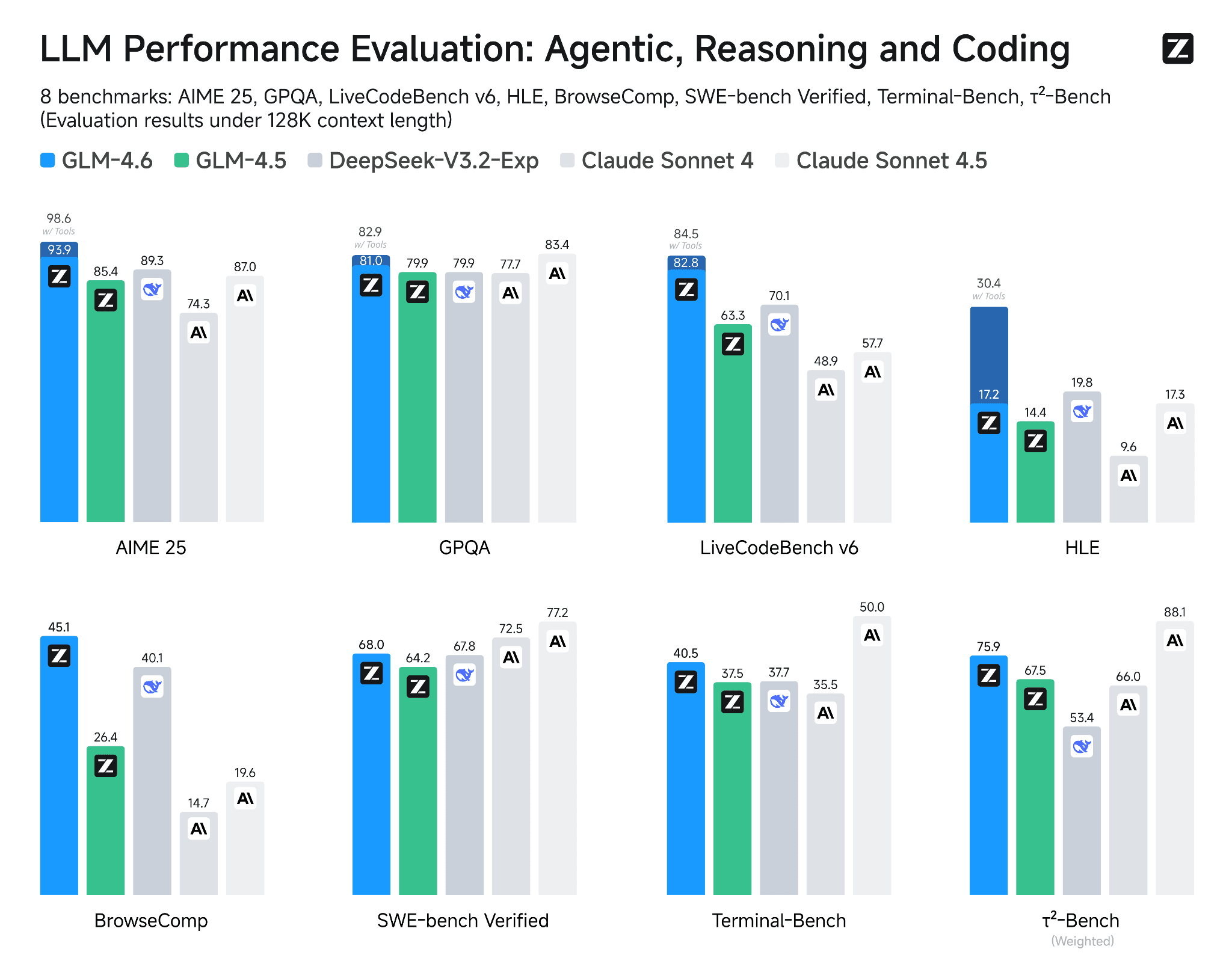

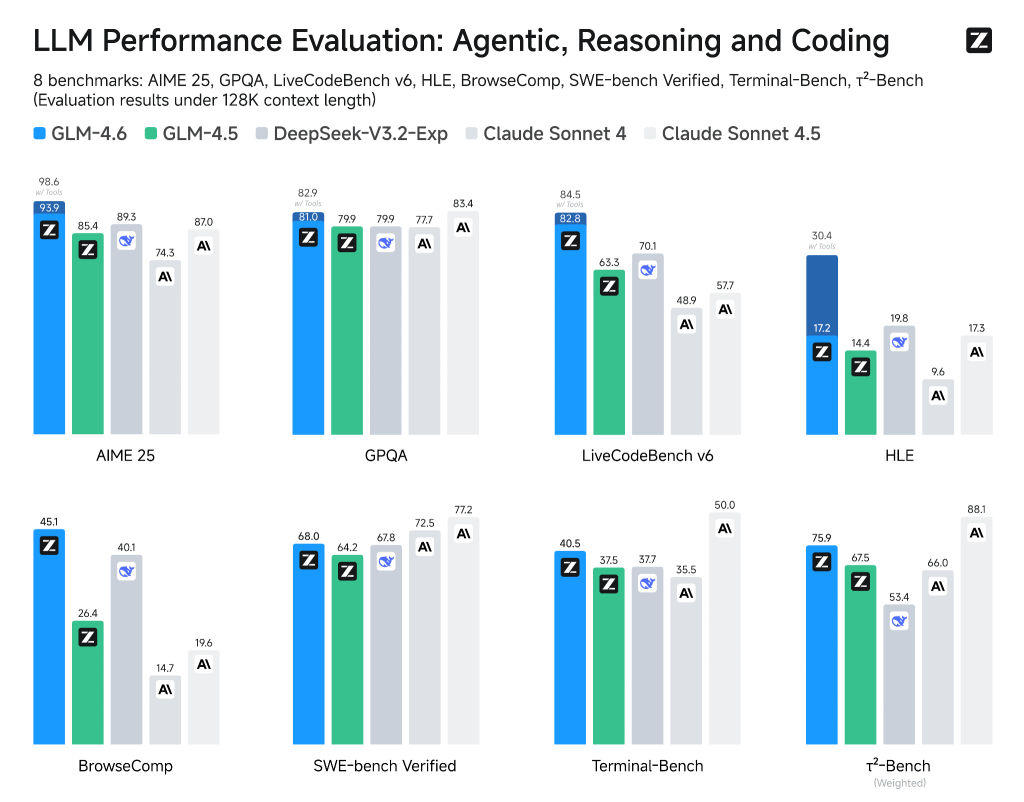

Model ini diuji di 8 benchmark utama seperti AIME 25, GPQA, LiveCodeBench v6, HLE, BrowseComp, SWE-bench Verified, Terminal-Bench, dan τ²-Bench.

Hasilnya?

- GLM-4.6 konsisten unggul atas GLM-4.5 dan model domestik lain.

- Di beberapa tes, performanya bahkan menyamai atau melampaui Claude Sonnet 4, salah satu model internasional terkuat saat ini.

- Misalnya di AIME 25 dan GPQA, GLM-4.6 mencatat skor di atas 80 poin, lebih stabil dibanding kompetitornya.

Evaluasi Coding Dunia Nyata

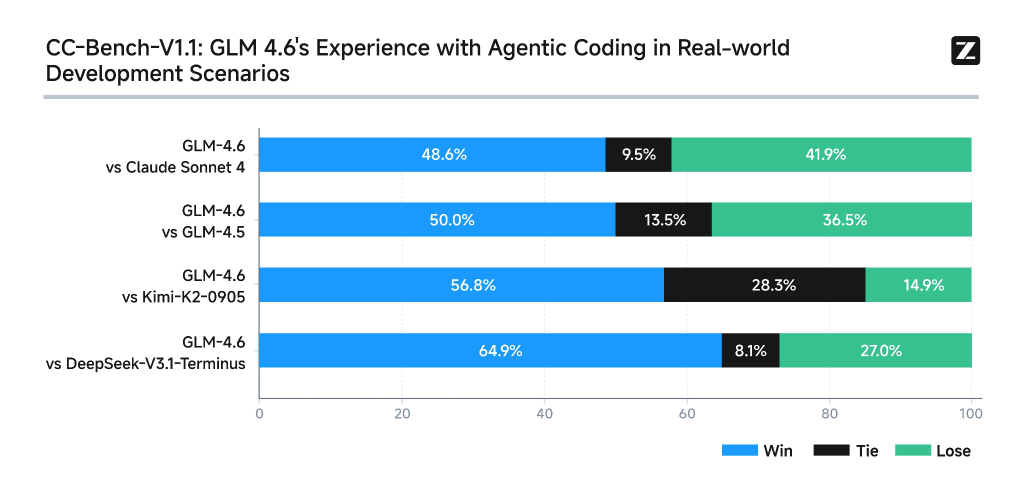

Untuk benar-benar menguji kemampuan coding, tim melakukan 74 tes real-world coding di lingkungan Claude Code.

- GLM-4.6 berhasil menang lebih dari 50% saat dibandingkan head-to-head dengan model lain.

- Termasuk unggul atas Claude Sonnet 4, DeepSeek, dan Kimi.

- Ini menunjukkan bahwa GLM-4.6 tidak hanya jago di benchmark sintetis, tapi juga tangguh di skenario coding nyata.

Efisiensi Token

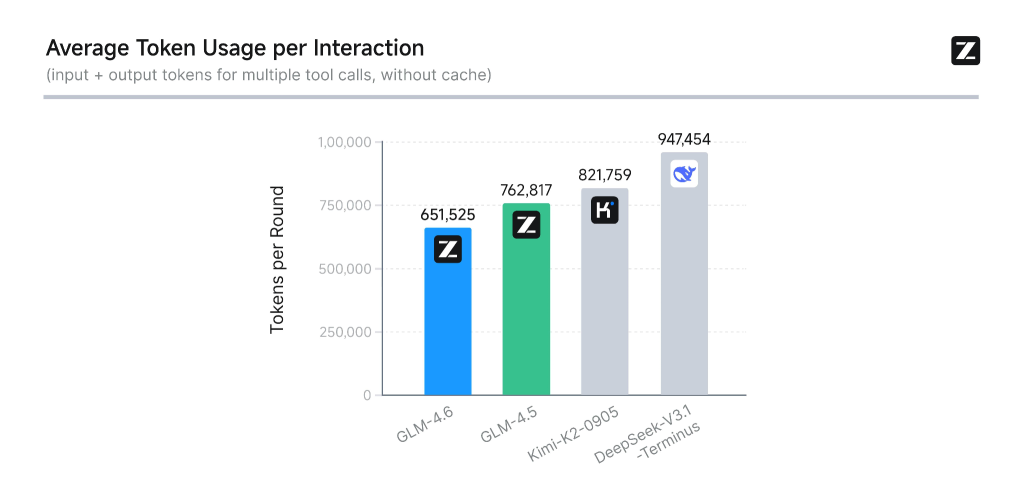

Satu hal yang sering dilupakan adalah biaya token. GLM-4.6 mencatat efisiensi luar biasa:

- 30% lebih hemat dibanding GLM-4.5,

- dan jauh lebih irit dibanding DeepSeek maupun Kimi.

Dengan konsumsi rata-rata hanya 651 ribu tokens per interaksi, GLM-4.6 menjadi model dengan penggunaan token terendah di kelasnya.

Ini berarti biaya lebih murah, respons lebih cepat, tapi kualitas tetap terjaga.

Rilis GLM-4.6 hanya dua hari lalu menandai langkah penting dalam persaingan global large language model.

Bukan sekadar update kecil, tapi sebuah lompatan besar: konteks lebih panjang, kemampuan coding nyata yang solid, reasoning lebih tajam, hingga efisiensi token yang jauh lebih hemat.

Dengan performa yang konsisten unggul di berbagai benchmark internasional dan hasil nyata di skenario coding praktis, GLM-4.6 menunjukkan bahwa ekosistem AI Tiongkok semakin mampu bersaing dengan pemain besar dunia seperti Claude maupun DeepSeek.

Bagi developer, peneliti, maupun praktisi AI, model ini jelas patut dicoba. GLM-4.6 menawarkan kombinasi kekuatan, efisiensi, dan fleksibilitas yang bisa membuka peluang baru dalam membangun aplikasi cerdas berbasis agen maupun sistem berskala besar.

Baca Selanjutnya

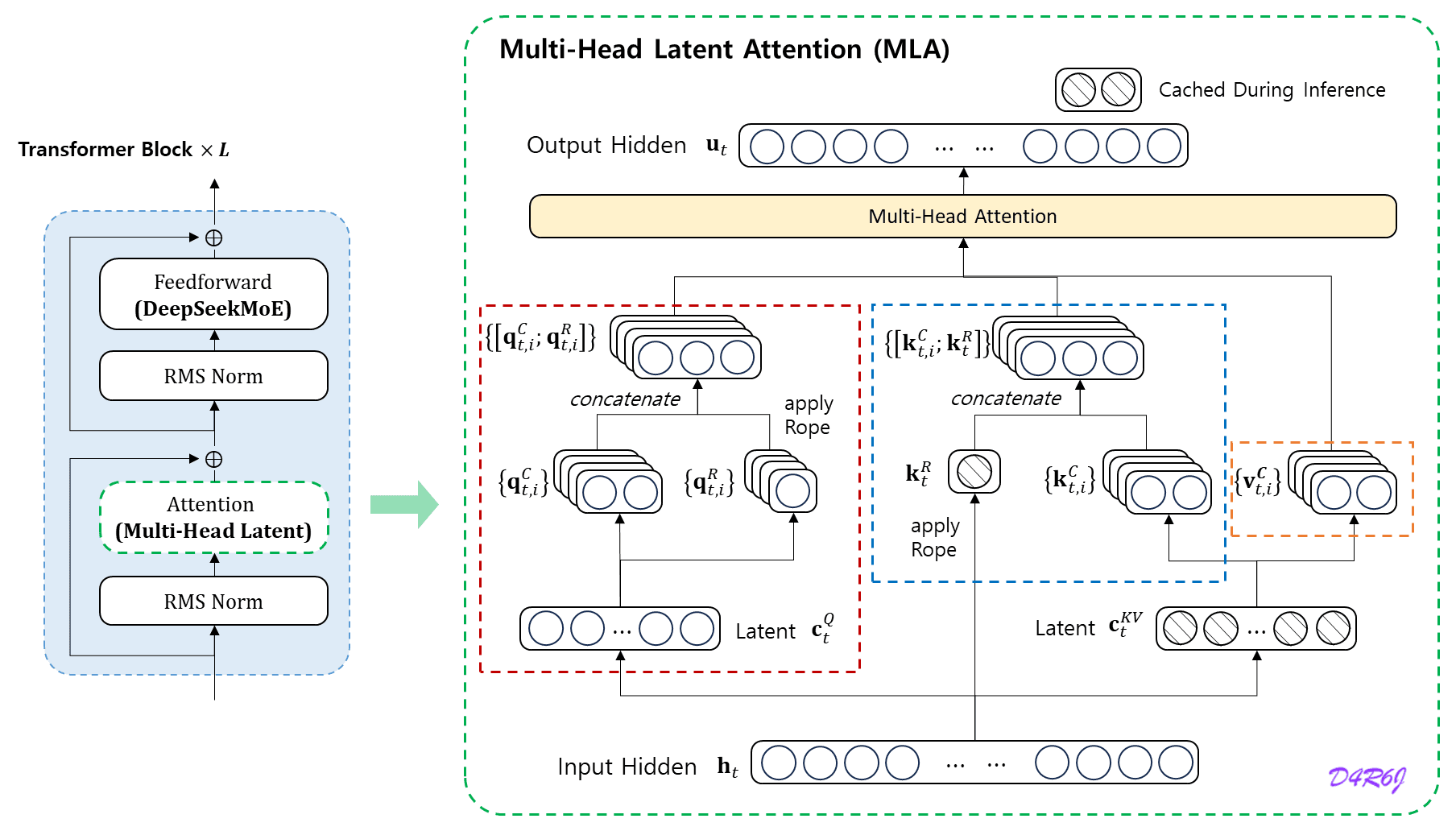

Apa Itu Multi-Head Latent Attention (MLA)? Rahasia Efisiensi DeepSeek

Dunia Artificial Intelligence (AI) belakangan ini sedang ramai membicarakan sebuah pergeseran besar. Jika sebelumnya kompetisi antar pengembang AI hanya berfokus pada siapa yang paling “pintar”, kini fokus tersebut meluas ke arah efisiensi. Kemunculan model-model terbaru, seperti DeepSeek, yang mampu menyamai performa model closed-source raksasa namun dengan biaya operasional yang jauh lebih rendah, memicu tanda tanya […]

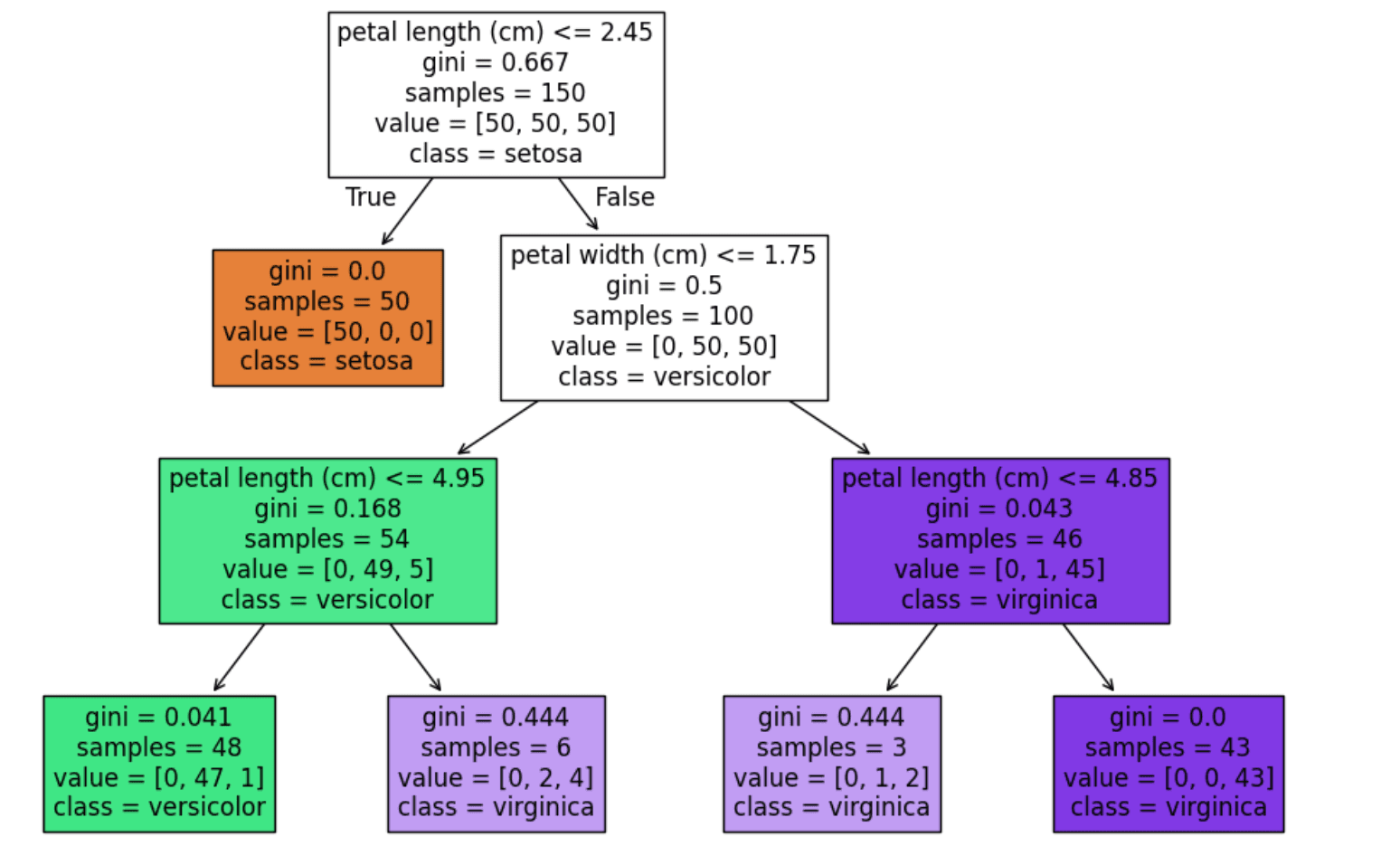

Decision Tree Classifier: Konsep, Cara Kerja & Contoh

Pernahkah kamu berpikir bagaimana sistem bisa membedakan email spam dari yang bukan? Atau bagaimana aplikasi kesehatan menebak penyakit dari gejala yang kamu isi? Salah satu algoritma machine learning yang sering dipakai untuk hal ini adalah decision tree classifier. Algoritma ini sederhana, mudah dipahami, tapi cukup kuat untuk menyelesaikan banyak masalah klasifikasi. Decision tree classifier bekerja […]